ほんとに4枚はいってる~とあけて、感動しました。

本題ですが、

本レビューではATOMボード4枚を用いてHPC(ハイパフォーマンスコンピュータ)を稼動させ、

LinpackBenchmarkでのFlops計算を行うことを目標とします。

できる限りキャプチャをとりたいところですが、慣れないLinux上で難しいため、

テキストが多くなってしまい、申し訳ありません。

検証環境は以下のように構築します。

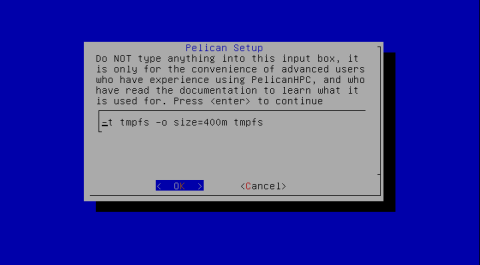

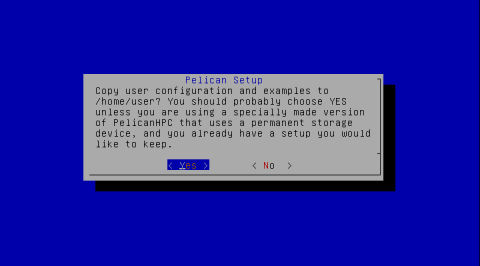

OSはPelicanHPC 2.5を利用します。

Cluster-Master,Nord1~3のすべてのマシンはそれぞれ

2Gのメモリを搭載し、Cluster-MasterのみDVDドライブを接続します。

GigabitEtherのスイッチについてはAllideTelesisのGS924Mを使用します。

BIOSについては、USBブートできないバグがあるため、最新版(2011/8/8)を利用します。

まず、Cluster-Masterを起動させます。

PelicanHPCはLiveDVDで提供されるため、DVDを作成しCluster-Masterでブートさせます。

今回はHDDを利用しないため、ファイルシステムをメモリ上に展開します。

次の画面でシステムのパスワードを決定すると、ログイン画面になります。

ログイン後

user@peli:~$ pelican_setup

を入力し、設定を行っていきます。

ここから先の基本的な流れとして

1. Start Pelican HPC netboot services →OK #PXEブートのサービスを起動

2. Restart Pelican HPC 表示されたらNode1~3を起動

→loginプロンプトまでNetbootで勝手に進む

3. Node1~3のすべてが起動完了したら、Master側でYesをEnter

4. 再度Restart Pelican HPC 表示される。

・Go turn on your compute node now と表示されるが

次行にAt the moment ** compute nodes としてNode数(今回は3)が正しく表示されていれば

yesをEnterしてsetupを抜ける。

Node数が正しくなければNodeの起動を確認してnoをEnter

5. 再度Restart Pelican HPC 表示される。OK Enter

・Masterを含むnode数が表示される。

6. HPC Test 実行される。各ノード上でMFLOPS表示

ここまででCluster-MasterにNord1~3が登録されます。

次にLinpackBenchmarkの実行準備です。

バージョンはHPL2.0を利用します。

まずコンパイルします。

/home/userから

cd hpl-2.0

sh SetupForPelican

念のため、この後にpelican_restart_hpcを実行してNordの再登録を行います。

登録が完了すると、/home/user/tmp/bhostsというファイルが作成されます。

実行の準備のため、このbhostsを書き換えます。

この作業は1core/nordの場合には必要ありません。

今回は2コアのATOMかつHyper-Threading Technologyを利用するため、

4core/1nordになるためです。

変更前のファイル内容は

10.11.12.13

10.11.12.14

10.11.12.60

10.11.12.1

になっていますが、これを

10.11.12.13

10.11.12.13

10.11.12.13

10.11.12.13

10.11.12.14

10.11.12.14

10.11.12.14

10.11.12.14

10.11.12.60

10.11.12.60

10.11.12.60

10.11.12.60

10.11.12.1

10.11.12.1

10.11.12.1

10.11.12.1

10.11.12.1

というように各IPに含まれているCore数分追加していきます。

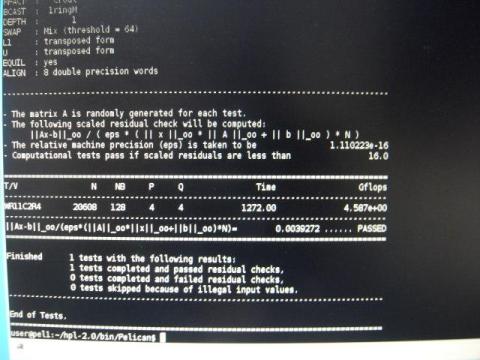

いよいよ実行していきます。

今回は事前にパターンを複数回実行し、結果のよかった設定を割り出し、

その試験を5回行い、アベレージで評価します。

cd /home/user/hpl-2.0/bin/Pelican

mpirun --hostfile /home/user/tmp/bhosts -np 16 xhpl

で実行します。

画面中央あたりで、xhplが25%程度ずつ4つ動いていることがわかります。

本来であれば、25*4で100になるはずですが、

リストの一番上、ksysguardが2%もっていってしまっているため、

合計値で98%の使用率になります。

これはCluster-Masterの値なので、これと同様のものが

Nord1~3で動いていることになります。

この結果だとGflops単位で 4.587e+00と出ていますので、

4.587Gflops

の演算結果です。

ちなみに、Timeが1272.00となっています。

この試験1回で21分ほどかかっています。これを5回繰り返します。

1回目:4.587Gflops

2回目:4.665Gflops

3回目:4.665Gflops

4回目:4.592Gflops

5回目:4.634Gflops

Ave:4.6286Gflops

消費電力はフル稼働状態で113Wでした

この結果はどのくらいなのでしょうか。

歴代のスパコンの演算速度から調べてみると

1993年前期の時点で世界第45位当たりだそうです。

PCでの例となると以前高校生が学校のPCをつないで

10Gflopsに迫るスコア(9.4757Gflops)を出したそうです。

そのときの構成が、2003年ころのPCで

Pentium4 2.4GHz、メモリ528M、100Base-Tの構成で64台の並列処理だそうです。

http://www.itmedia.co.jp/enterprise/articles/0411/08/news...

今回は4台で5Gflops近い値を出していることを考えると、単純に1台1Gflopsと考えると

64台も稼動させると64Gflops近い値が出そうです。

(実際にはもっと低いと思います)

現在のHPCはCPUの並列演算にとどまらず、GPUまで活用するそうですが、

日本のスーパーコンピュータ「京」の例もありますし、

科学技術の進歩ってすごいですね。

ここまででひとまずの検証結果とさせていただきますが、

Hyper-Threading TechnologyをOFFにしたとき結果など、

時間のあるときに追加でやってみたいと思います。

久しぶりに楽しい時間でした。

コメント (0)

YouTube の動画を挿入

YouTube の URL または動画の ID を入力してください

動画の ID が取得できません。ID もしくは URL を正しく入力してください。

ニコニコ動画の動画を挿入

ニコニコ動画の URL または動画の ID を入力してください

動画の ID が取得できません。ID もしくは URL を正しく入力してください。

ZIGSOWリンク挿入

検索対象とキーワードを入力してください

外部リンクを挿入

リンク先の URL とタイトルを入力してください

URL を正しく入力してください。

ほかのユーザーのレビュー

-

インテル® デスクトップ・ボード D525MW BOXD525MW

レビューインフィニティ第3弾「原始星雲」のレビュアーに選出していただきありがとうございます。まさかレビューに選出されるとは思ってなか�...

-

インテル® デスクトップ・ボード D525MW BOXD525MW

今回は10枚ものmini-ITXボードを評価する機会を与えて下さりありがとうございました。クラスタ構成を構築するにあたり、数回に分けて報告しま�...

-

インテル® デスクトップ・ボード D525MW BOXD525MW

=初めに=この度は、原子星雲に採用いただきありがとうございました。このような場を与えてくださった、intel様、Zigsow様に深く御礼申し上げま...

ZIGSOWにログインするとコメントやこのアイテムを持っているユーザー全員に質問できます。