1.Introduction

さて、高耐久/NAS Readyを売り文句に登場したWDのHDD「WD Red」のレビューをやることになりました。

自分の家では、家庭内ファイルサーバーとしてSolarisを運用しているんですが、

そこのzfs-RAIDにWD Redを追加してその使い心地を検証してみたいと思います。

2.Guide had said what talks is Red?

さて今回レビューとして使用するWD Redですが、

「NAS上での利用に特化した高耐久仕様」ということになっています。

送られてきた外観と基盤のレイアウトからの推測ですが、

「Caviar Green 1TBプラッタ品の選別品にNAS向けのファームを書き込んだもの」

と見て良いようです。

もともと、Caviar Greenというのは廉価なことで人気のあるHDDでしたが、

省電力にファームを振りすぎてNASやRAIDで使うとあっという間に故障する

ことでも有名になってしまったモデルでもありました。

その辺の話は以前日記でも書いたことがあります。

もともとファームがRAIDやNAS向けでないことを除けばキャビ緑は悪いHDDではなかったですし、

ちゃんと選別品に対応ファームを乗せたうえで24時間保障してくれるなら

RAID環境やNAS環境で使う価値は十分にあると思えます。

特に4代以上のRAID構成で使うのであれば、個々のHDDの速度差はあまり関係なくなりますし、RAID中の一台の候補としては十分に考えらえれるでしょう。

最近SeagateがRMA保証期間を1年に短縮したこともあり、

保証期間3年というのも、キャビ黒の5年には及ばないにしろ安心できます。

(これでRMAの送り先が海外でなければなあ・・・)

2.Tell it Like it Z-F-S

zfsというのは、Sun MicroSystems(現Oracle)がSolaris用に開発したファイルシステムで、

- 柔軟性の高いソフトウェアRAIDで高耐用性/高パフォーマンスなストレージを構築できる

- SnapShot/Clone機能で柔軟な世代管理/バックアップを行える

- 128bitのセクタ管理機能によりZetaByte(100万TB)までのファイルが扱える

- 強力な重複排除機能を持つ

といったところが特徴です。

現在、SolarisとFreeBSD(及びそれらの派生であるNexentaやFreeNAS等)でプロダクションレベルで使用でき、

Linuxでは現在RCレベルで開発が進んでいます。

Linuxではほぼ同等の機能を持つBrtfsが開発中ですが、まだ安定性や性能ではzfsに一日の長があります。

今回はiSCSIも合わせて運用しますので、iSCSI周りの性能が高いSolaris系のOpenIndianaで使用することにします。

3.Let's Celebrate

今回のハードウェア構成はこんな感じで

CPC:Core i7-3770

Shuttle SZ-77R3から移植。

そのうちXeon E3に載せ替えるつもりですが当面こっちで。

M/B: ASUS P8B WS

サーバー用チップセットのC206を積んだワークステーション用マザー。

C206(と後継の216)は、Sandy/Ivy世代のサーバーチップセットの中で、

唯一ECC/NonECC両対応のチップセットになります。

これもつなぎとしてNonECC DIMMを使うために使用。

Case:JMAX FM500B

今回のレビューのために購入。

今回、ちょっと変わった使い方、というか、ただの外付ホットスワップベイとして使います

VGA:玄人志向 RADEON HD 7750/Sappire RADEON HD 3450

なんでファイルサーバーにVGA2枚?って思う方もいるかもしれませんが

今回、ESXiを使って、仮想マシンにファイルサーバとVDIマシンを同居させるつもりなので

そちらでVGAを使うつもりです

Mem:A-DATA 4GB PC1333*2

これはいちいちもちもの登録してませんでしたが、まあそのへんに転がってた奴でw

PCI SATA I/F:玄人志向 SATARAID5-LPPCI

今回、マザボのSATAポートを全てゲストにパススルーするので、

このままだとESXiのデータストアが使えなくなります。

そこでESXiで認識できればなんでもいいということで、

PCI SATAのやっすいカードを調達しました。

4.I Threw A Block Through A Window

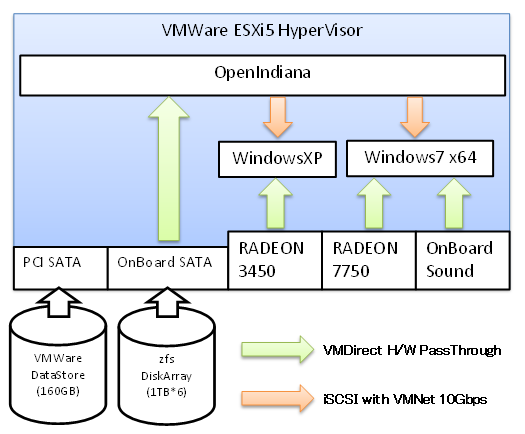

今回のシステム構成はこんな感じ

VMWare ESXi5で仮想ハイパーバイザを作り、

OpenIndianaにSATAコントローラをパススルーしてHDD6台をRAID化し、

VGAとサウンドをWindowsにパススルーして使います。

WindowsとOiは10Gbpsの内部ネットワークでつながる、というか

一度ホストにiSCSIとして流してWindowsのストレージとして使います。

こうすることでネットワークのボトルネックをほぼ気にせずにzfsの速度を得られるわけですね

5. Six Horsemen

ということで組立に入ります

今回使用するHDD6台を並べてみました。

右上が期待の新人WD Red君ですね。

こうしてみると、笑っちゃうぐらいHDDのモデルがバラバラですね。

ハードウェアRAIDじゃないので、容量さえある程度同じなら機種違いとかを全く意識しないでいいのもzfsのいいところです。

どうせなら6台全部違ってればネタとして美味しいんですが、

残念ながらHGSTだけ2台かぶっちゃいましたw

ケースに6台突っ込んでみます

一番上が空いてますが、ここはブートドライブ用にキープで。

そして今回のシステムの一番の白眉といいますか、一番のネタといいますか・・・

このリムーバブルの電源とSATAを別ケースにつなぎこみます

素直にリムーバブルのモバイルラック買えよという話もあるんですが、

5インチベイ搭載のリムーバブルラックよりこのケースの方が安いんです

6.Girls from Indiana goes to Greenland

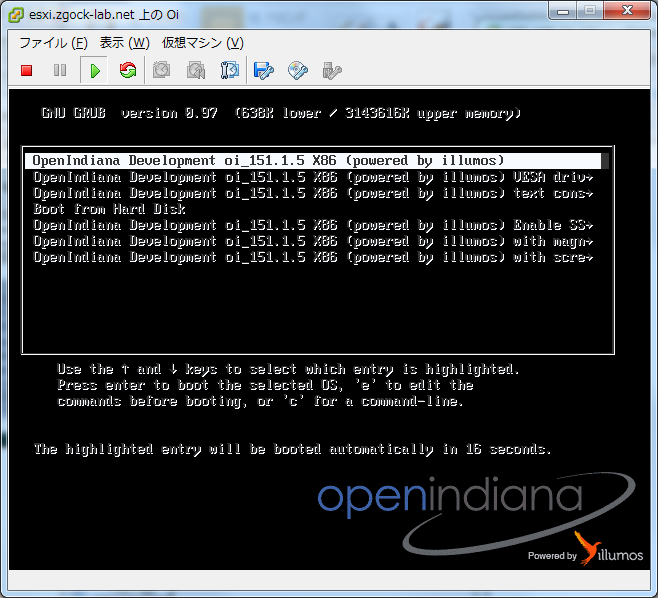

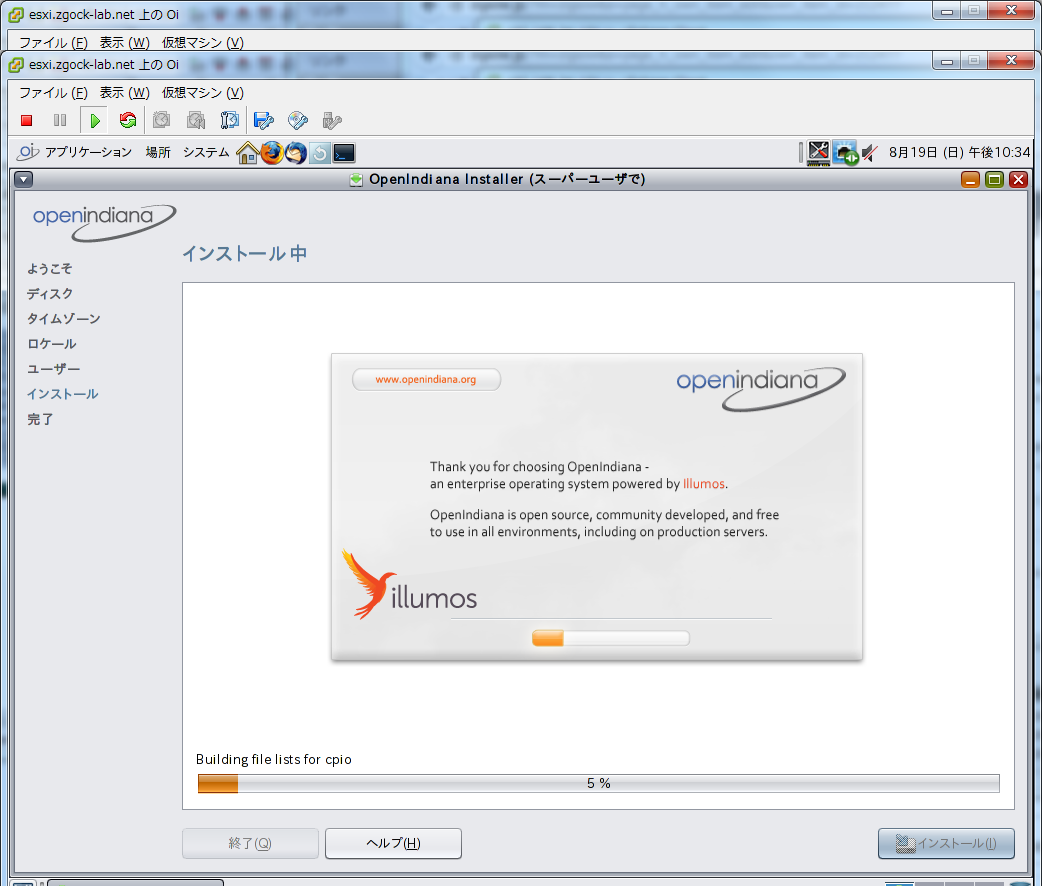

160GBのブートHDDにESXi5をインストールして起動。

データストア上にインストール用isoをコピーして、

30GBほどのvmdkファイルを確保してOpenIndianaをインストールします

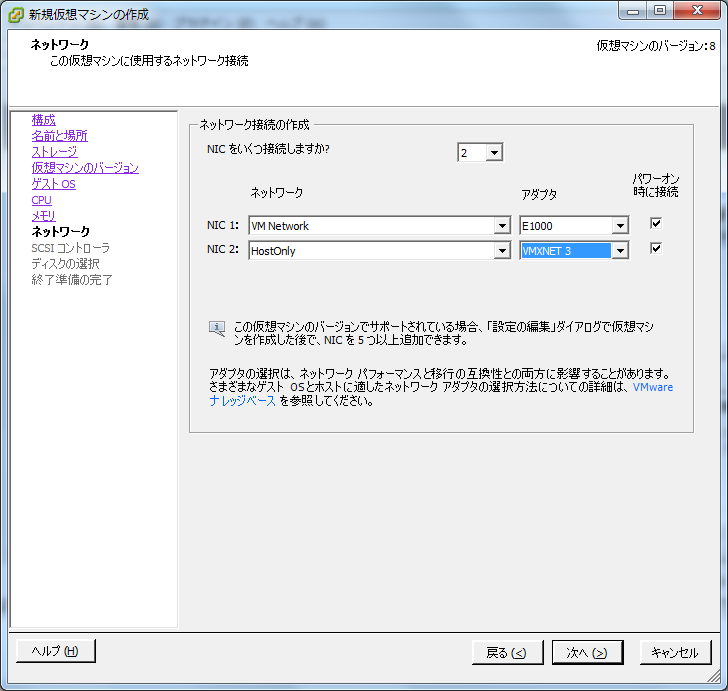

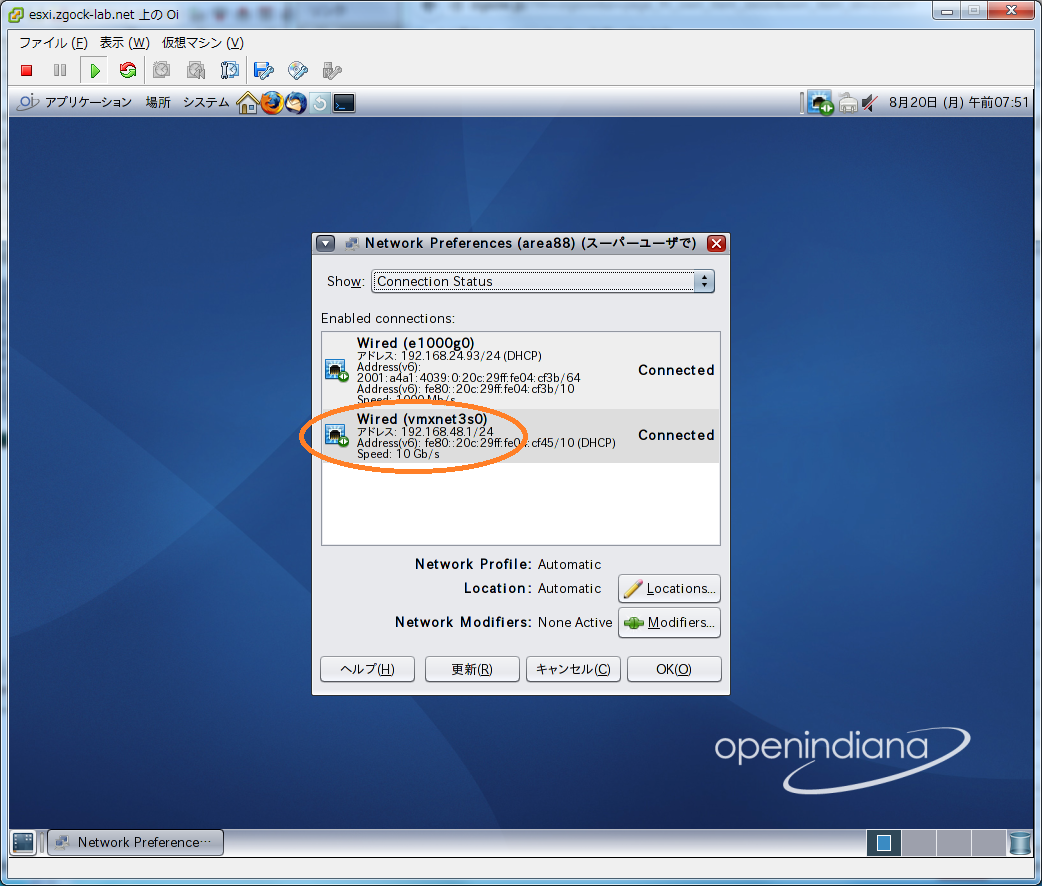

ここでのポイントは、外部向けのブリッジネットワークに加えて、

もう一つ内部ネットワーク用のVMNETインターフェースを用意しておくことです。

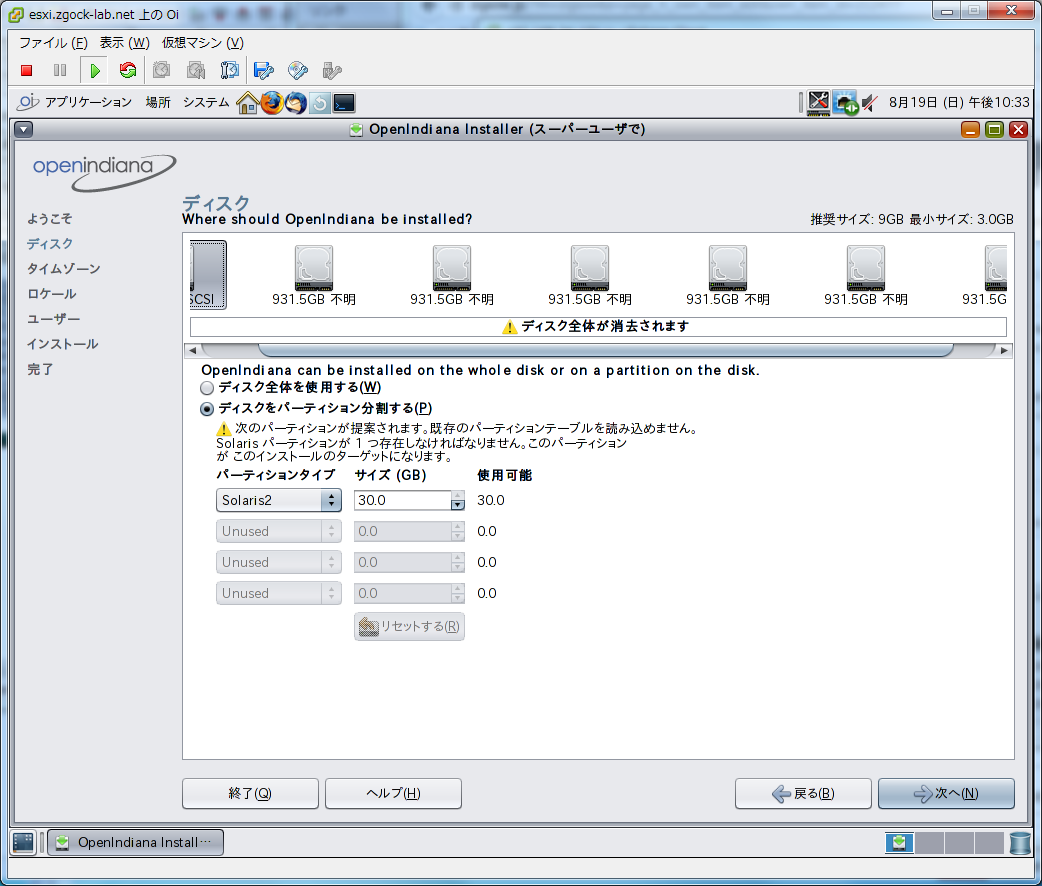

後はマザボのSATAコントローラをOiにパススルー設定してインストール開始。

インストーラ上でパススルーされたSATAコントローラ上にぶらさがった6台のHDDが認識されているのがわかります。仮想で作った30GBと合わせて7台ですね。

ということで、あれこれ設定してインストール。ホストネームですが、

混成HDDアレイが、「なんか外人部隊みたいだ」と思ったので

「area88」をホストネームにしましたw

インストール後、VMWare-toolsをインストールすると、VMNETとして追加した2ndのNICがホスト間で10GBpsでリンクアップします。

こちらにzfsでボリュームをiSCSI公開すれば10GBpsのESXiストレージとして使えます。

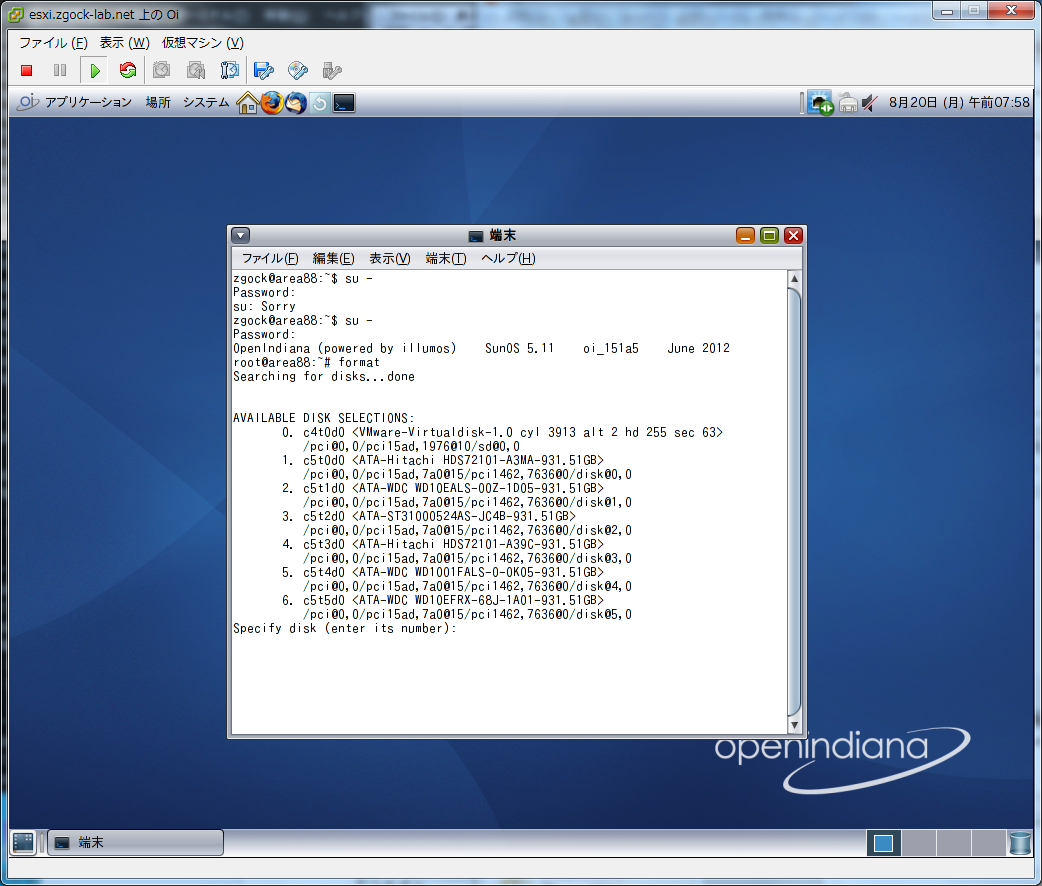

formatでdiskIDを確認。

はい、笑っちゃうぐらいディスクがバラバラですね。

ハードウェアRAID組むならあり得ない構成ですw

ここで6台をRAID化するんですが、今回はRAID-6相当のRAID-Z2でアレイを構築します。

これで6本のHDDのうち2本までの故障に耐えられるようになりますので、

家庭内使用であればまあそうそう壊れないでしょう。

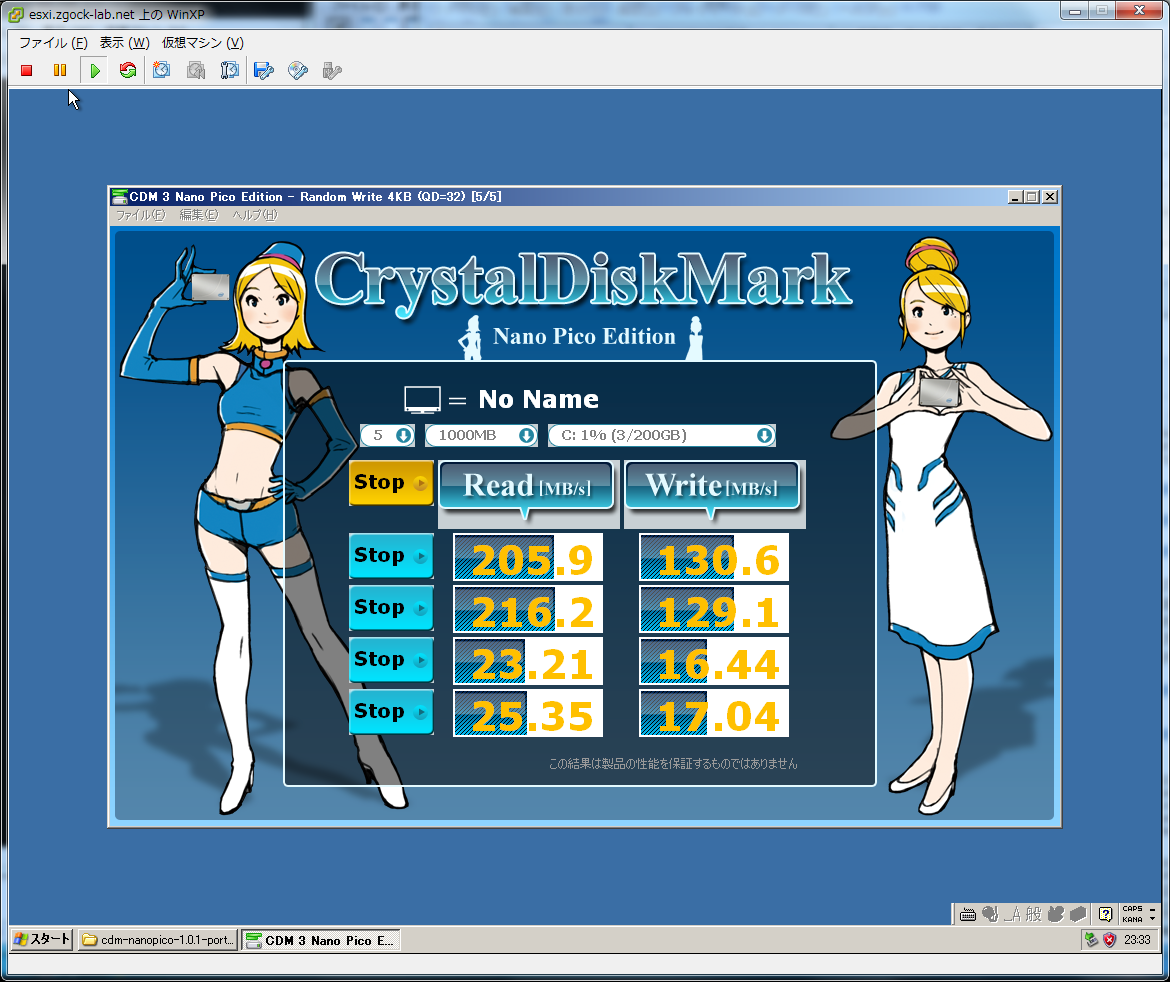

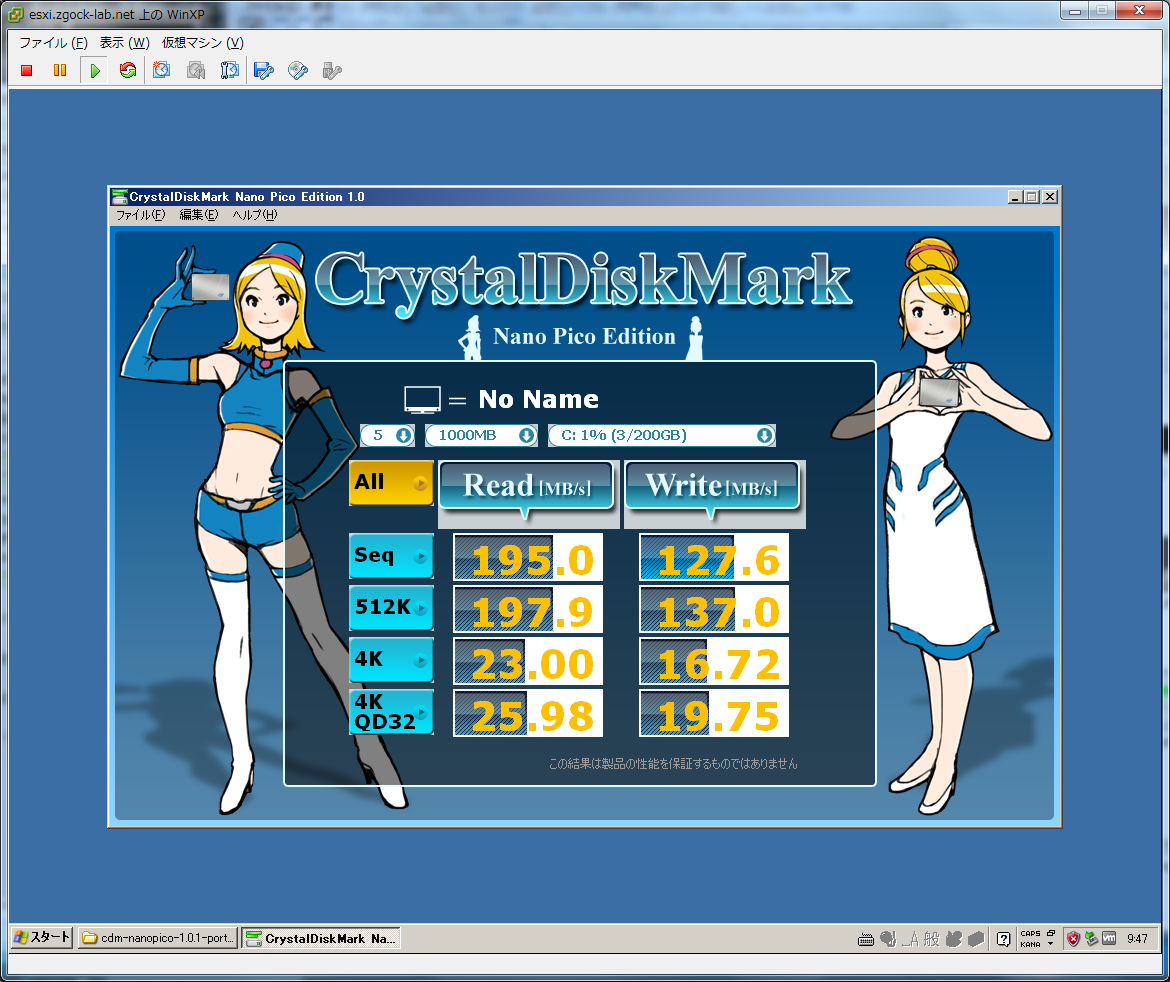

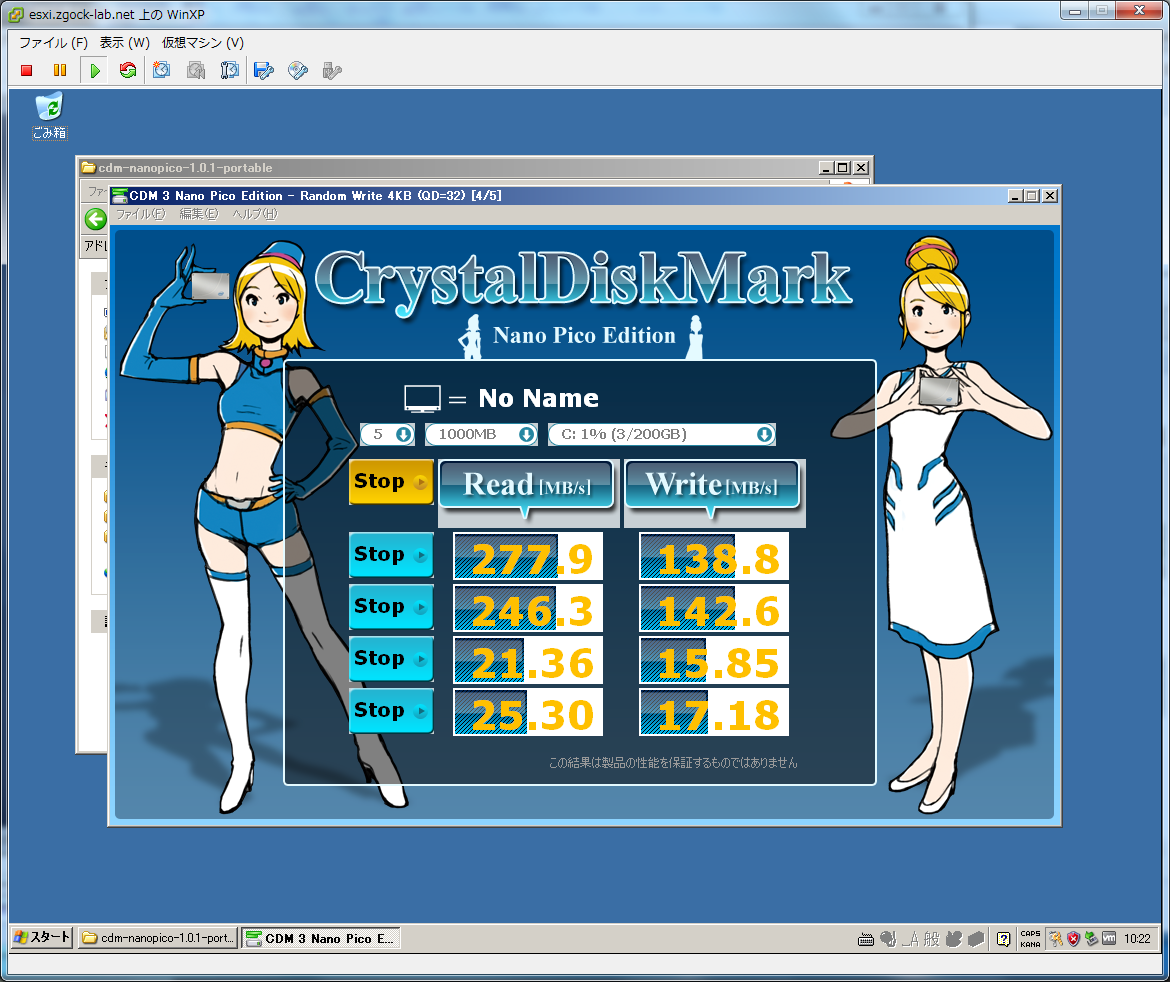

若干先走りますが、検証用にWindowsXPを仮想にインストールして、

3種類のRAID構成でNanoPicoを取ってみました。

a.HDD*6をRAID-Z2(RAID-6構成)

b. HDD*3をRAID-Z、3台のアレイをRAID-0 (RAID-5/0構成)

c.HDD*6をRAID-Z(RAID-5構成)

さすがにRAID-Zだと読み書き性能もかなり高く、かつHDD一本分総容量が増えるのは魅力的ですが、家庭内LANの基幹ストレージになることを考えて安全性でRAID-Z2でいくことにします。

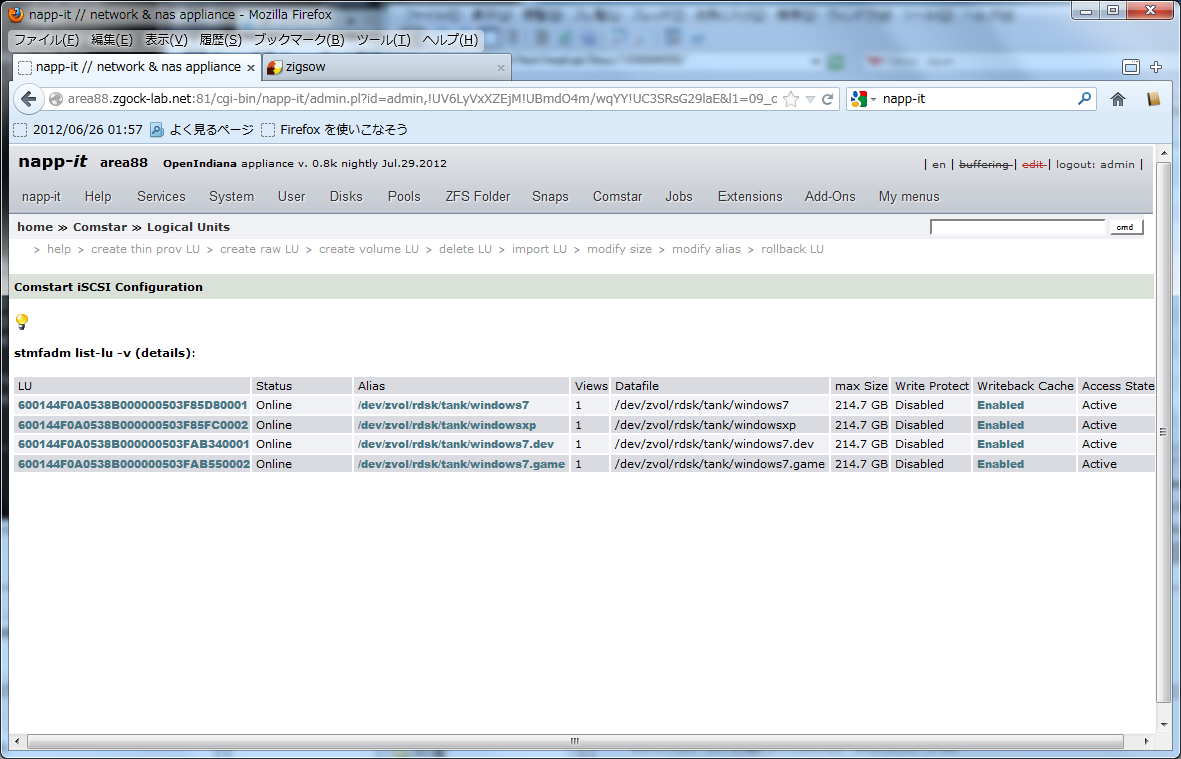

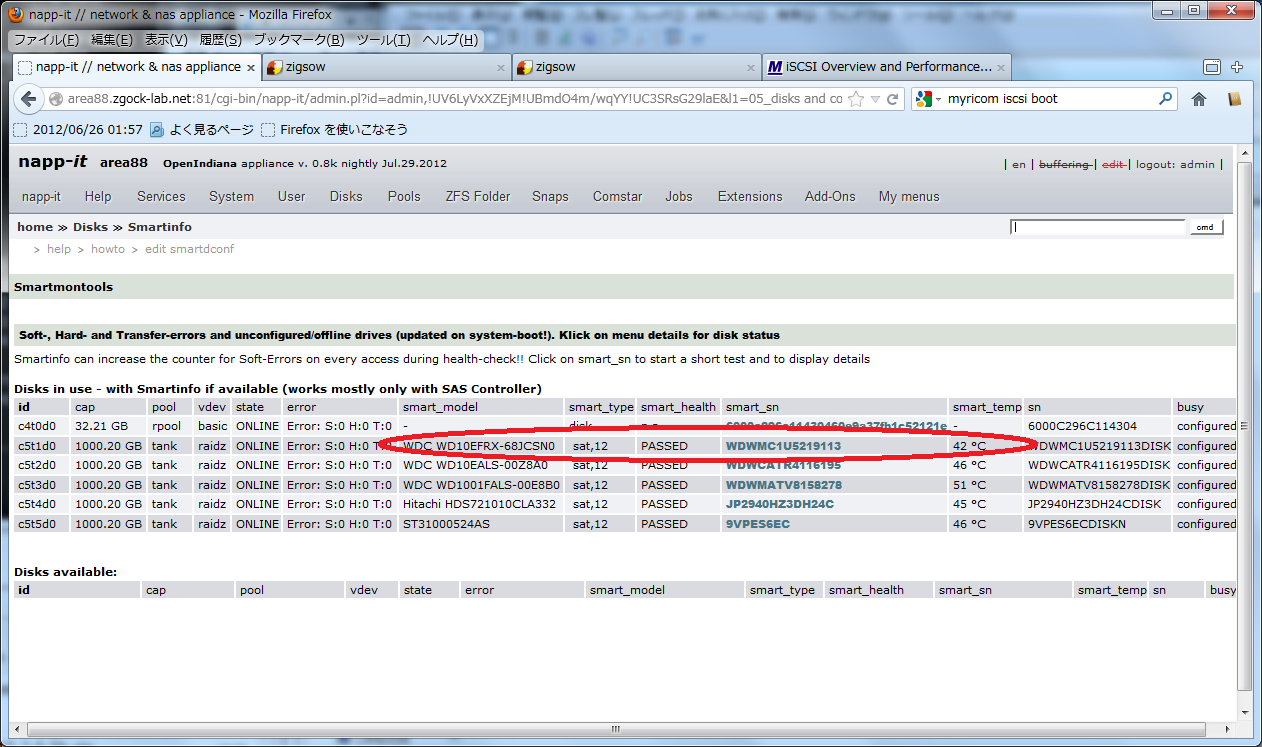

7.Napp-it,yes you can Napp-it

openIndianaにweb管理ツールのnapp-itをインストールして、

Windows7用とWindowsXP用にそれぞれ200GBのiSCSI領域を切り出して公開します。

ちょっとこの時スクリーンショットを撮り忘れてしまったんで、clone設定後の状態になりますがこんな感じで。

でもって、切り出したiSCSI領域をESXiの物理ディスクマッピングに割り当ててWindowsをインストールします。

Windows標準のリモートデスクトップでは、DirectXが使えないためVGAパススルーをする意味がなくなるので、DirectX対応のリモート接続ソフトを入れますが、自分が愛用しているのはMirror-DTCというソフトウェアです。

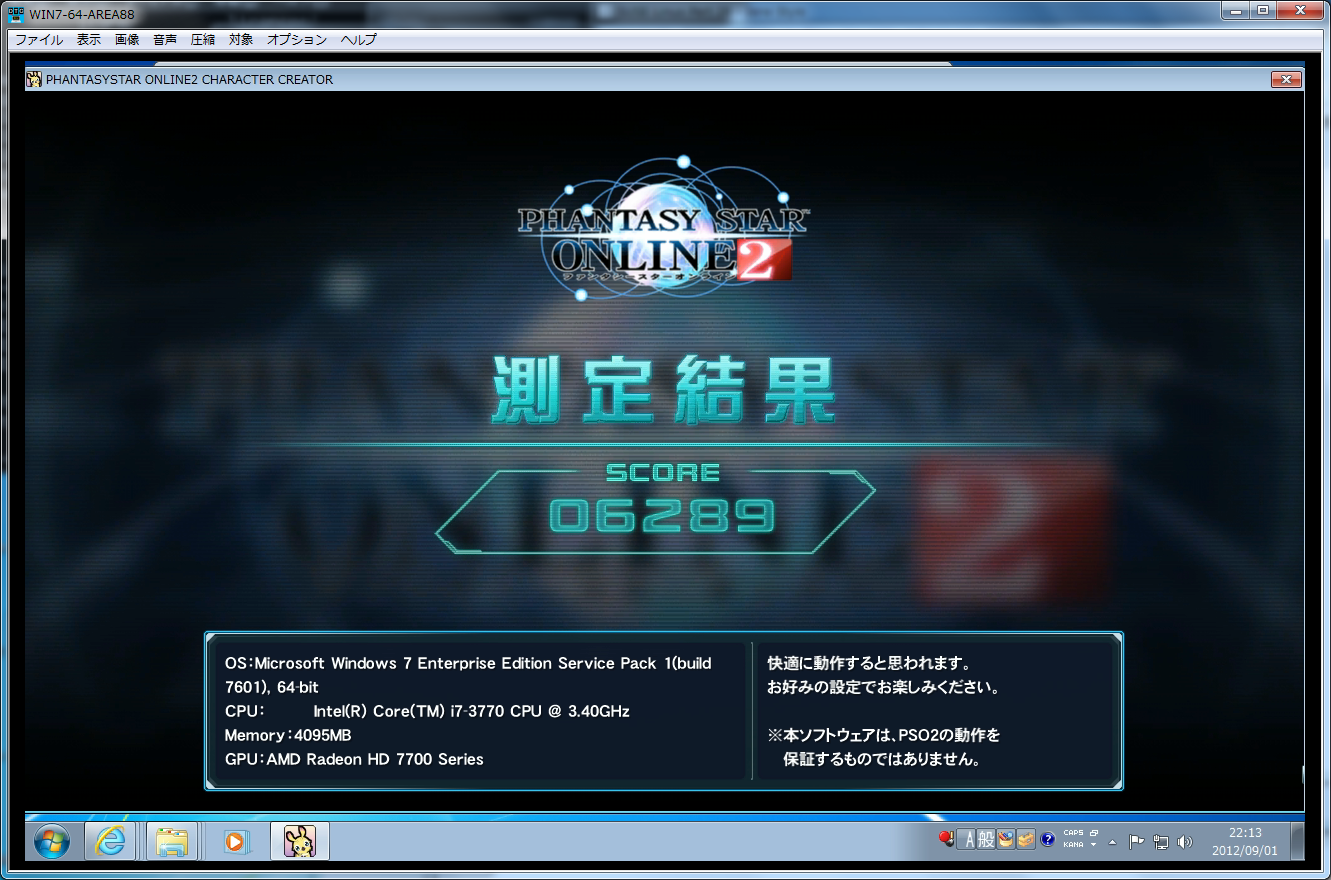

Windows7にRADEON7750とサウンドカード、WindowsXPにRADEON3450をそれぞれパススルーしてインストールします。

Windows7の方にメモリ4Gと論理コア4つを割り当てて、なんちゃってCore-i5仮想マシンの誕生です。

PSO2ベンチ(標準)で6200

ゆめりあで65000と、RADEON7750+Sandy Core-i5ぐらいのスコアは普通に出ています

でもってNanoPicoは

メモリが多いせいか、VMWareのドライバがSCSIエミュレートのせいか、XPよりいい数字が出てますね。

ちょっと前のSSD程度の数字は出ていると思います。

8.White Heat, Red Hot

こんな状況でストレージサーバ&VDIクライアント2つ(&雑用のLinuxも1つ)動かした状態で、

napp-itでHDDの状況を確認するとこんな感じで

WD RedのHDD温度が他と比較して明らかに低いのがよくわかります。

というか、Caviar Black君の爆熱ぶりもよくわかりますねw

9.Always clashing in the same car

さて、そんなこんなでzfs+VDI環境をテストしていたわけですが、

実はその間に、WD Red君がBIOSから認識されなくなるというトラブルがありました。

調べてみたところ、どうやら基盤が電気的に故障したようで、

プラッタ周りとファームが高耐久仕様になっていても、基盤はCavi緑と同じですので、

壊れるときはやっぱり壊れるんだなあという結論には達しましたw

やむを得ずzigsow運営さんに連絡して代替品を送っていただいたのですが、

その間、HDD一台引き抜かれた状態でもパフォーマンスには全く影響がありませんでした。

おそらく実使用での故障が発生した場合、家庭内使用であればRMA交換することになると思いますが、WDの場合、RMA送付先が海外のため、修理品到着までどうしても2週間はかかります。その2週間の間、とりあえずもう一台壊れてもなんとかなるraid-z2のありがたみを感じました。

数日後、送られてきた交換品を突っ込むと自動的にraidの再構築が走ります。

ハードウェアRAID5/RAID6を構築された方ならご存知だと思いますが、

普通のRAID5/6でディスク一台交換するとRAIDの再構築に恐ろしく時間がかかります。

(今回のような1TB*6とかの環境だと1日~2日は余裕でかかります)

が、zfsではファイルシステムとRAIDシステムが一体化していますので、

その時点で使用されている容量分だけRAID再構築を行いますので、

今回のケースであれば、2時間強でRAID-Z2の構築が完了しました。

10.Fond adieus but never say goodbye

そんなこんなで、電気的故障というトラブルはありましたが、これは個体差だと認識しています。

raid-z環境を構築して数日経過していますが、その後全くトラブルはなく、

ストレージサーバを含むゲスト4台は極めて安定して動いています。

その間も定期的にHDDの状況を監視していましたが、WD Redの温度の低さは常に目立っていました。

もちろん長期的な耐久性についてはもっと長期のテストをしないとなんともいえませんが、

すくなくとも常時稼働しているサーバー用の一台としては、十分候補に加えられる一台だと思います。

最後になりましたが、レビューの機会を与えてくださったzigsow運営様、ならびにWestern Degital様、そして最後までこの無駄に長いレビューをお読みくださった方に感謝の意を表しつつ、レビューを終わりたいと思います。

ありがとうございました。

ZIGSOWにログインするとコメントやこのアイテムを持っているユーザー全員に質問できます。